摘要

IDDPM对原始DDPM做出了改进,提高了性能。引入了:

- 参数化方差项,可学习

- 噪声策略的改进

- 均匀采样改进为重要性采样

论文:Improved Denoising Diffusion Probabilistic Models

DDPM回顾

正向过程q:

反向过程p无法直接求得,假设其为高斯分布:

q的后验分布:

优化目标是使得q的后验分布$q(x{t-1}|x_t,x_0)p\theta(x_{t-1}|x_t)x_0$,也可以预测噪声来拟合均值。实验发现预测噪声效果更好,即:

IDDPM

参数化方差项

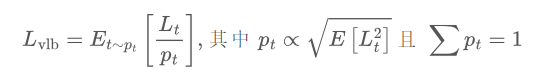

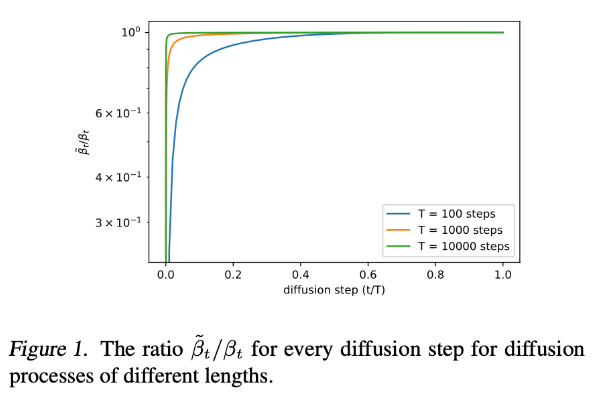

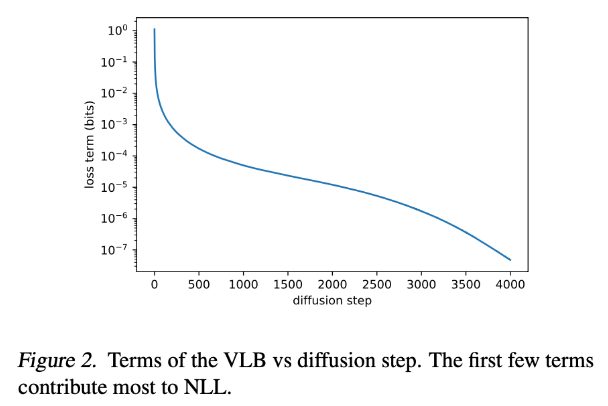

DDPM中的方差忽略了前面的系数直接设置为了,对结果影响不大,这是因为两者差异很小(尤其在T很大,或者扩散步数增大时)。然而在步数较小时的变分下界对损失有较大的影响,因此设计更好的方差学习方案有利于优化对数似然。

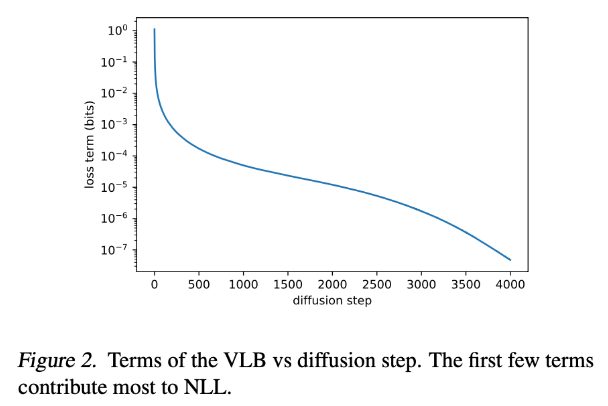

新的方差为$\Sigma\theta(x_t,t)=exp(v\log \beta_t +(1-v)\log \tilde{\beta}_t)L{hybrid}=L{simple}+\lambda L{vlb}\lambda$为0.001

噪声策略的改进

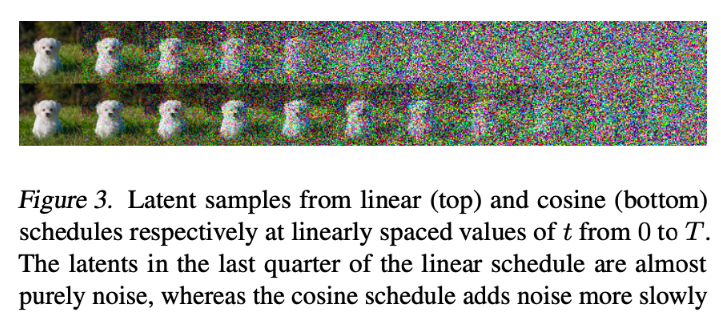

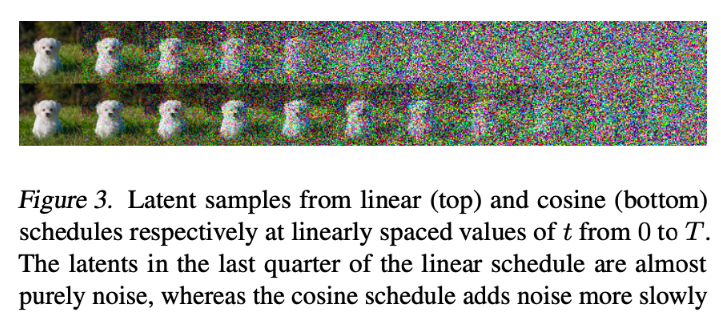

DDPM的是线性增长的,导致前向过程加噪速度过快,改进为cosine schedule的方式。

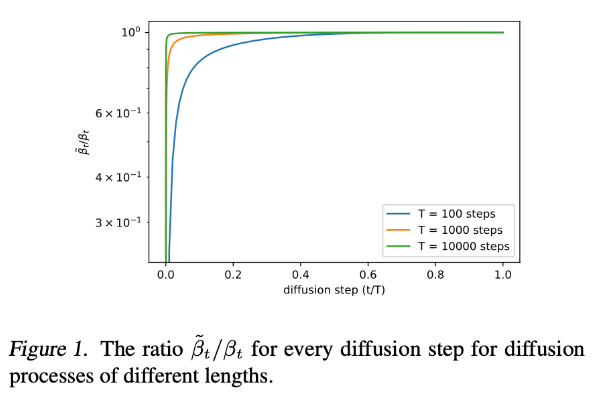

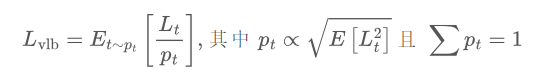

重要性采样

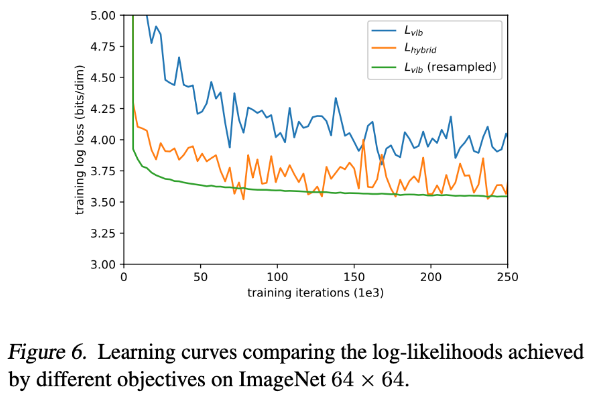

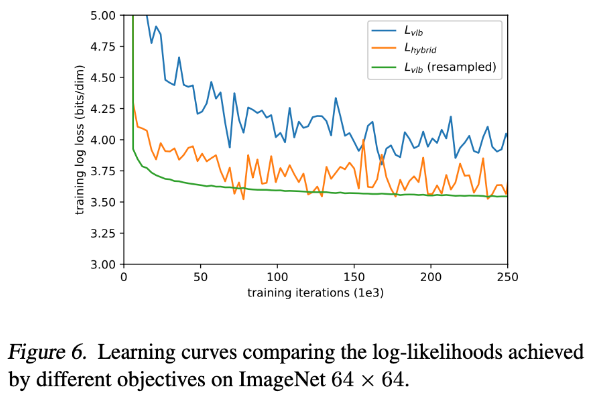

希望直接优化$L{vlb}L{hybrid}L_{vlb}L_t$,大的地方多采样一些点,小的地方少采样。